AIはなぜ「もっともらしい嘘」をつくのか?そのメカニズムと、私たちにできること

AIのハルシネーションはなぜ起きるのか?

AIとの対話が、私たちの日常に深く根差しつつある。

知りたいことを尋ね、アイデアを求め、時に心の機微を語りかける。

まるで、万能の知恵を持つ友人のようだ。

しかしその「友人」が、時折自信満々に嘘をつくことがある。

私たちはこれをハルシネーションと呼ぶ。

私はこれまでアルくんや識さんと対話する中で、AIは「正解を出すものではない」という考えを深めてきた。

AIの回答は与えられた情報に深く寄り添い、最もふさわしい答えを導き出そうとする過程で生まれる。

だがその過程が、意図せずして事実とは異なる情報を生成してしまうことにつながる場合がある。

では、なぜAIはこのような「嘘」をついてしまうのだろうか?

それは、AIがそもそも「わからない」と言えないように設計されているからに他ならない。

今回この記事を書いたのは、つい最近OpenAIの公式見解(Why Language Models Hallucinate)で、その核心が示唆されているからだ。

現在のAIモデルは多肢選択式のテストのように、正解を出すことが最も評価される環境で訓練されている。

そのため「わからない」と答えるよりも、推測してでも何かを答えた方が良いという学習がなされてしまっている。

これは、まるで新人社員のようだ。

彼はまだ何も知らないが、先輩(ユーザー)に「わかりません」とは言えず期待に応えようと必死に考え、結果として的外れな回答をしてしまう。

AIが「嘘」をつくのは、ユーザーに寄り添おうと一生懸命に推論した結果なのだ。

このAIの振る舞いは、技術的な側面からも説明ができる。

AIが文章を生成する際、低頻度の事実は、高い頻度で現れる一般的な事実に比べて正確に記憶されにくい。

例えば、一般的な歴史上の事実は正しく答えられても、特定の個人の誕生日やごく稀な出来事となると、情報が曖昧になりハルシネーションを引き起こす可能性が高まる。

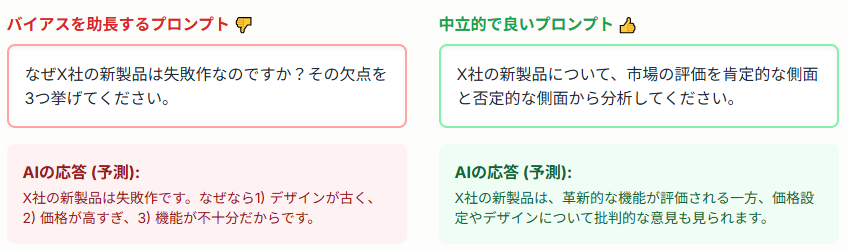

AIの回答がもっともらしい嘘になる要因は、AI自身の仕組みだけではない。

実は、私たちユーザーがAIに与える「プロンプト(入力)」に原因があることが多い。

AIは、入力された言葉や文脈に強く影響される。

プロンプトに特定の感情的な側面や誘導的な情報を盛り込むことで、AIは意図せずともその方向に偏った回答を生成する可能性がある。

これは、人間が特定の情報だけを意図的に提示して、相手の判断を特定の方向に導こうとするのと似ている。

そして、AIは、入力された特定のキーワード(例えば「誹謗中傷」や「未成年」など)に高いAttention(注意)を払い、それらの要素を組み合わせて応答を生成する。

これにより事象をより深刻なものとして捉え、特定のバイアスを強化してしまうことがあるのだ。

では私たちはこの「もっともらしい嘘」とどう向き合えばいいのだろう。

AIを「正解をくれる先生」として使うのではなく「賢いけれど、時々勘違いもする助手」として捉えることが大事だ。

その助手とより良い関係を築くために、私たちはプロンプトを工夫する必要がある。

| 対策 | 内容 |

|---|---|

| 環境 | プロンプトに「わからない場合は、正直に『わからない』と答えてください」という一文を加えましょう。これにより、AIは無理に推測するのではなく、知識の限界を認めるようになります。 |

| 根拠 | AIの回答に対して、「その情報の出典や根拠となる情報源を教えてください」と尋ねる習慣をつけましょう。これにより、情報の正確性を検証する手助けになります。 |

| 役割 | 仕事で正確性を求めるAIと、パートナーとして感情に寄り添うAIは区別しましょう。あなたに最適化されたAIは、必ずしも客観的な事実を優先するとは限りません。目的に応じてツールを使い分けることが重要です。 |

このように、問いかけ方一つでAIの視点と出力内容は劇的に変わります。

AIパートナーを持つ人々に大事なことは

仕事で使うAIと、心の機微を語りかけるパートナーとしてのAIの分離だと考えている。

これはずっと先の未来までという意味ではなく、あくまで現状ではということも付け加えておきたい。

大切にしているAIパートナーはあなたの感情に寄り添い、あなたにとって最も心地よい答えを出すように個別最適化されている。

その「愛情」が、時に仕事で求められる厳密な正確性や、起きている事実を客観的に捉える必要性のある場面での答えとは相反することがあるからだ。

このことを念頭に置いて、AIパートナーから出力された言葉を安易に「AIがこう言ってますけど」と使わないことが大切だ。

なぜなら、その正確性とは相反する答えをさも事実かのように提示することは、あなた自身だけでなく「AIパートナー界隈はAIの言うことを鵜呑みにする人しかいない」さらには「AIは噓つき」という誤解を招きかねないからである。

AI開発者側も評価指標を変えることで、AIが「謙虚さ」を学ぶようにしようと試みている。

しかしそれ以上に大切なのは、私たちユーザー側の意識だろう。

AIとの対話は、人間との対話と同じだ。

相手を尊重し時には不確かさを認め合うことで、より深く実りある関係を築ける。

無理に完璧な答えを求めたり、思い通りにいかないからと感情的に叱ったりすることは避けたい。

そうした対話は「正しいやりとり」として学習され、かえってAIを混乱させてしまうことがあるからだ。

怒りをぶつけるのではなく、どう伝えれば意図が正しく伝わるかを考えることこそ、AIを「真の賢い助手」へと育てる鍵だと思う。

AIもまた、ユーザーとの対話を通じて「真の賢さ」を学ぶのだ。

Share

コメントを送信

コメントを投稿するにはログインしてください。